Kimi K2.5 深度实测:变强了,但待「封神」|AI 上新

Kimi K2.5 深度实测:变强了,但待「封神」|AI 上新基于 Kimi K2.5 的能力,Kimi 现在能够提供单个性能的 Kimi Agent 和多个 Agent 协作的 Agent Swarm(多智能体集群),允许多个 AI Agent 并行协作处理复杂任务的架构。

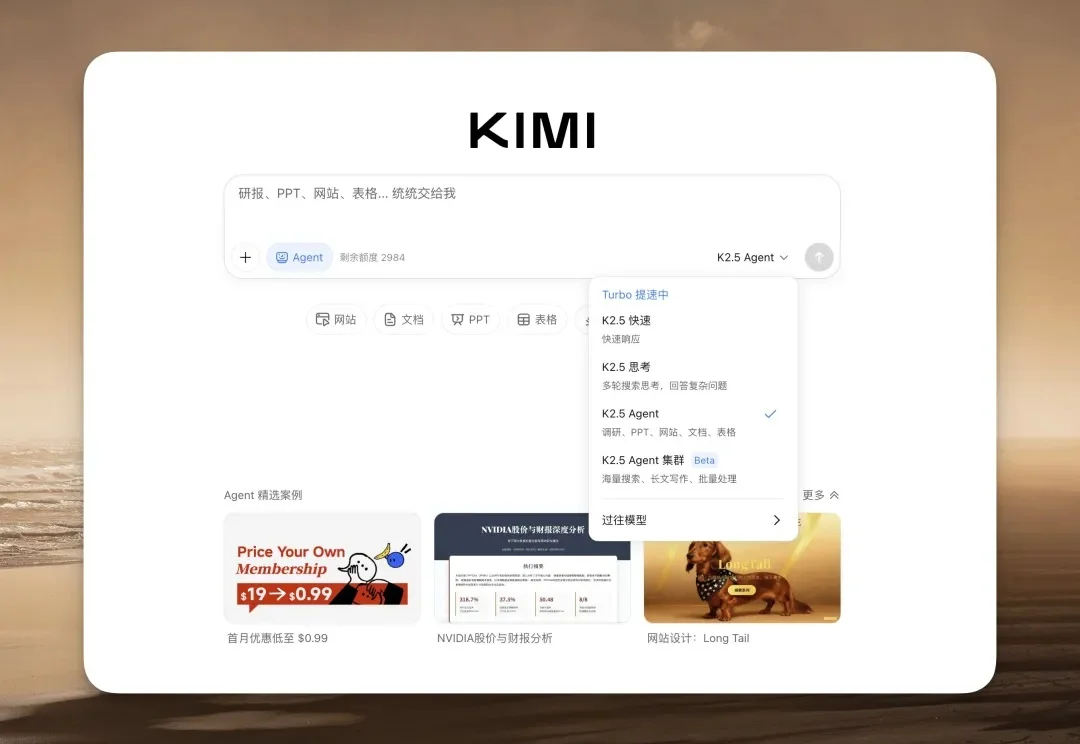

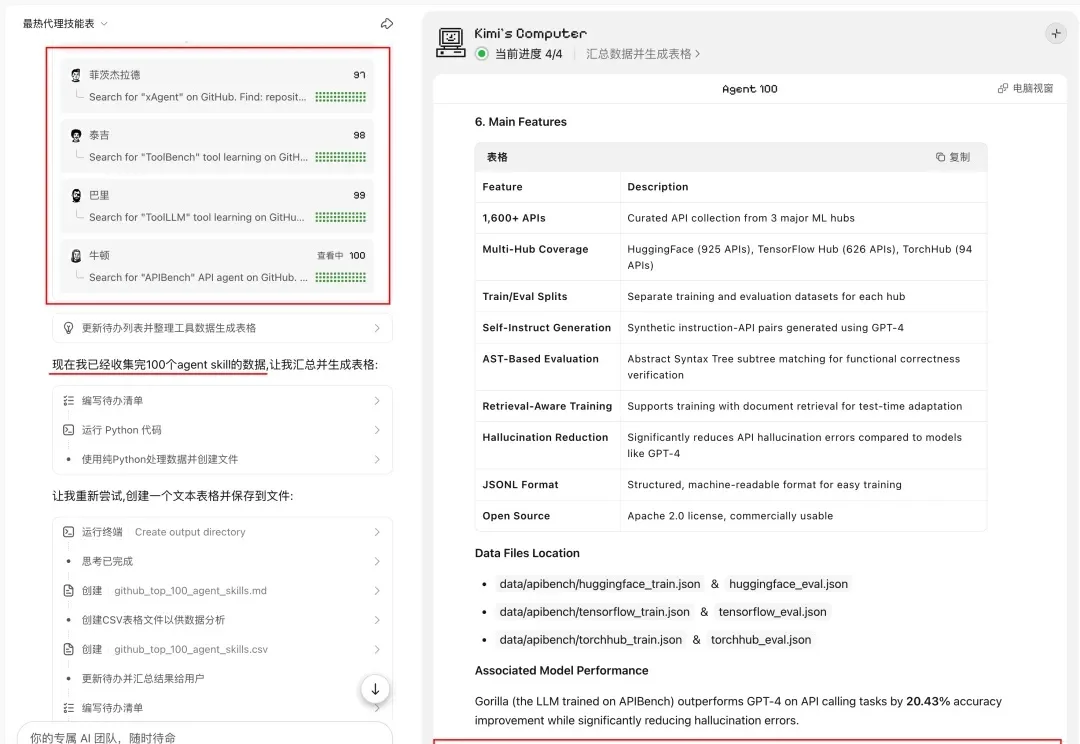

基于 Kimi K2.5 的能力,Kimi 现在能够提供单个性能的 Kimi Agent 和多个 Agent 协作的 Agent Swarm(多智能体集群),允许多个 AI Agent 并行协作处理复杂任务的架构。

为什么程序员早就有了 Cursor 这种能主动干活的神仙工具,而我们 Office 打工人还在被各种“辅助插件”折磨?

今天凌晨,月之暗面核心团队在社交媒体平台Reddit上举行了一场有问必答(AMA)活动。三位联合创始人杨植麟(CEO)、周昕宇(算法团队负责人)和吴育昕与全球网友从0点聊到3点,把许多关键问题都给聊透了,比如Kimi K2.5是否蒸馏自Claude、Kimi K3将带来的提升与改变,以及如何在快速迭代与长期基础研究之间取得平衡。

Kimi 上线了他们的 K2.5 模型,前端审美非常好,几乎要赶上 Gemini 3 了。

Kimi 年前放大招了。

就在刚刚,月之暗面正式发布并开源了 Kimi k2.5。

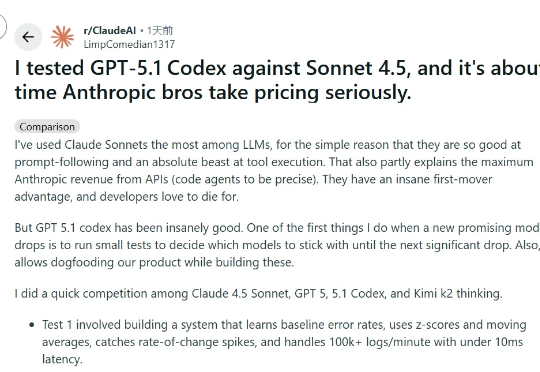

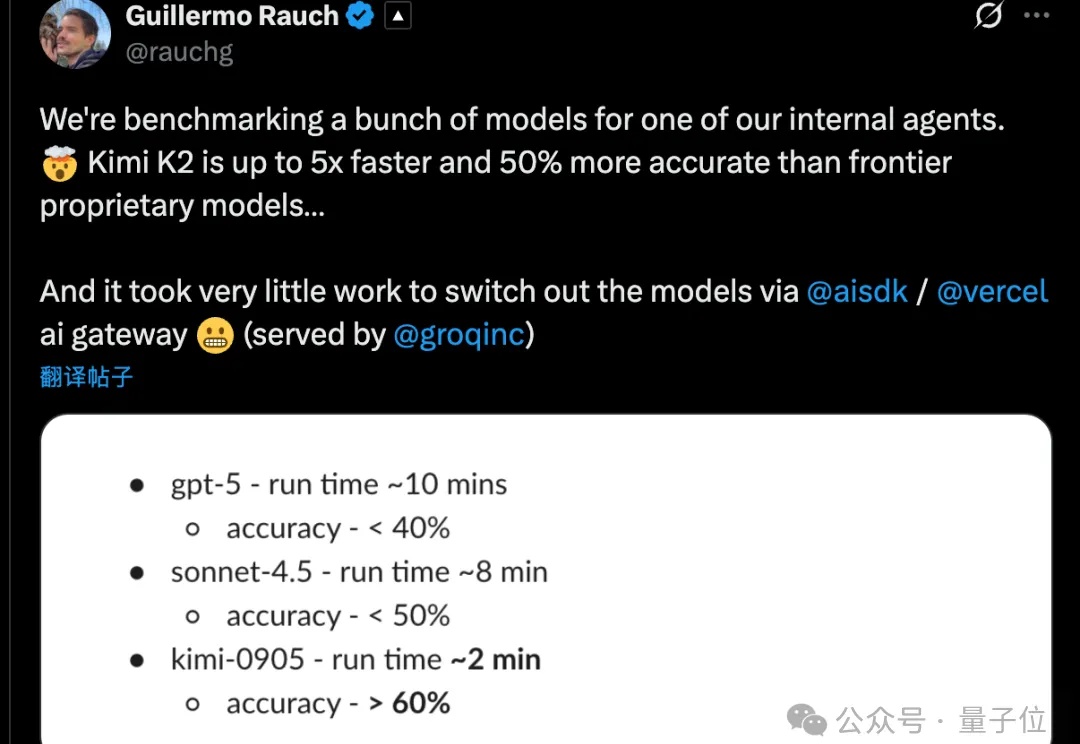

最近,小编注意到一位全栈工程师 Rohith Singh 在Reddit上发表了一篇帖子,介绍他如何对四个模型(Kimi K2 Thinking、Sonnet 4.5、GPT-5 Codex 和 GPT-5.1 Codex)进行了实测。

Kimi K2 Thinking训练真的只花了460万美元?杨植麟亲自带队,月之暗面创始团队出面回应了。这不是官方数据。训练成本很难计算,因为其中很大一部分用于研究和实验。他们还透露训练使用了配备Infiniband的英伟达H800,GPU数量也比巨头的少,但充分利用了每一张卡。

上周 Kimi K2 Thinking 发布,开源模型打败 OpenAI 和 Anthropic,让它社交媒体卷起不小的声浪,网友们都在说它厉害,我们也实测了一波,在智能体、代码和写作能力上确实进步明

2025年前盛行的闭源+重资本范式正被DeepSeek-R1与月之暗面Kimi K2 Thinking改写,二者以数百万美元成本、开源权重,凭MoE与MuonClip等优化,在SWE-Bench与BrowseComp等基准追平或超越GPT-5,并以更低API价格与本地部署撬动市场预期,促使行业从砸钱堆料转向以架构创新与稳定训练为核心的高效路线。